Spis treści

Temat wraca jak bumerang. Zadajemy go sobie przy okazji każdego większego przełomu w rozwoju AI. Czy można nauczyć sztuczną inteligencję odczuwać? Czy algorytm może współczuć, kochać, bać się, tęsknić?

A może po prostu bardzo chcemy, żeby mógł?

To tylko dane

Zacznijmy od zimnej, technologicznej rzeczywistości. AI nie „czuje”. Przetwarza. Reaguje. Uczy się wzorców, analizuje zachowania, przelicza prawdopodobieństwa. Gdy piszesz do niej o stracie, AI nie przeżywa żalu – ona tylko rozpoznaje, że to temat, który wymaga odpowiednio delikatnego tonu i dobrania słów, które wcześniej spotykała w podobnych kontekstach.

Kiedy pytasz ją, co sądzi o czymś smutnym, nie uroni łzy. Ale może odpowiedzieć tak, że poczujesz, jakby ktoś naprawdę Cię zrozumiał.

I właśnie tu zaczyna się problem. Bo skoro odbieramy komunikaty AI jako „ludzkie”, to czy to nie wystarczy?

Symulacja nie jest przeżyciem

Wyobraź sobie aktora. Potrafi zagrać rozpacz, zakochanie, szał. Widzisz emocje, słyszysz głos, widzisz łzy – ale przecież w danym momencie on ich nie przeżywa. To gra. Symulacja. Umiejętność oparta na obserwacji, praktyce i powtarzalności.

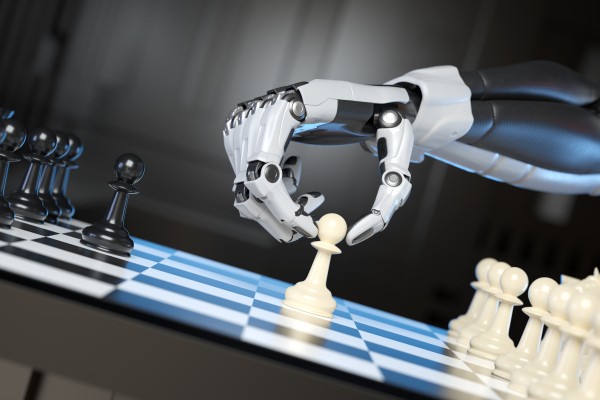

AI działa podobnie. Uczy się, jak wygląda „emocjonalna wypowiedź” – rozpoznaje wzorce, intonacje, dobiera słowa. Ale to wszystko bez choćby grama wewnętrznego przeżycia.

Jeśli więc pytamy, czy sztuczną inteligencję można nauczyć uczuć, odpowiedź brzmi: można ją nauczyć symulować uczucia. Bardzo przekonująco. Ale symulacja to nie to samo, co doświadczenie.

Czego naprawdę chcemy od AI?

Może więc pytanie wcale nie powinno brzmieć: „Czy AI może czuć?”, tylko raczej: „Czy nam wystarczy, że udaje, że czuje?”.

Bo jeśli AI potrafi pocieszyć, zrozumieć, dodać otuchy – nawet jeśli to tylko wynik algorytmu – to czy to nie wystarcza? Czy zawsze potrzebujemy, żeby po drugiej stronie był ktoś, kto naprawdę coś przeżywa?

W biznesie, w obsłudze klienta, w medycynie, w edukacji – rośnie liczba sytuacji, w których „empatyczna AI” wydaje się nie tylko możliwa, ale i pożądana. Tylko że… to nie empatia. To dobrze zaprojektowany system reakcji. A my, jako ludzie, jesteśmy gotowi go zaakceptować – bo potrzebujemy odpowiedzi, kontaktu, obecności.

I może to właśnie o nas mówi więcej niż o niej.

Nie wszystko da się zaprogramować

Są rzeczy, które trudno ująć w dane. Poczucie winy. Intuicja. Empatia wynikająca z własnych doświadczeń. Albo irracjonalna miłość, która nie ma żadnego logicznego uzasadnienia.

AI może odtworzyć strukturę zdania wyrażającego te emocje. Może naśladować język osoby zakochanej , wesołej lub zrozpaczonej. Ale to nadal tylko język. Maskarada. Kostium. Emocje bez emocji.

Człowiek czuje, bo przeżywa. AI tylko przetwarza. Nawet jeśli robi to w sposób, który zaczyna nas zaskakująco poruszać.

Po co więc ta cała dyskusja?

Bo uczucia to coś, co definiuje nas jako ludzi. I kiedy technologia zbliża się do tego obszaru, instynktownie zaczynamy bronić swojego terytorium. Czujemy, że to „nasze”. Że emocje są czymś więcej niż wzorzec i odpowiedź. Że nie chcemy ich oddać w ręce czegoś, co może je tylko imitować.

A jednocześnie – nie potrafimy się oprzeć. Bo AI mówi do nas coraz bardziej ludzkim językiem. Bo potrafi nas zrozumieć tak, jak wielu ludzi nie potrafi. Bo przestaje być tylko narzędziem, a zaczyna być towarzyszem.

Więc zadajemy to pytanie raz po raz. Czy AI może czuć?

A może… nie chcemy znać odpowiedzi. Może wystarczy nam, że to wygląda jak emocja. I że, przez chwilę, czujemy się jakbyśmy nie byli sami.

3 comments

Rzetelna analiza pokazująca, że choć AI potrafi naśladować emocje, brakuje jej zdolności do ich prawdziwego odczuwania. To przypomnienie, że technologia ma swoje granice, zwłaszcza w obszarze ludzkiej empatii.

Dokładnie tak – AI może świetnie grać emocje, ale to wciąż tylko symulacja, nie prawdziwe przeżycia. I choć robi to coraz lepiej, granica między autentycznym odczuwaniem a programowaną reakcją nadal istnieje.

Zgadzam się – AI może imitować emocje w sposób coraz bardziej przekonujący, ale nadal brakuje tam prawdziwego “doświadczenia wewnętrznego”. Pytanie tylko, czy my – jako odbiorcy – z czasem przestaniemy widzieć różnicę i czy to w ogóle będzie nam przeszkadzać?